人工智能简答题小结

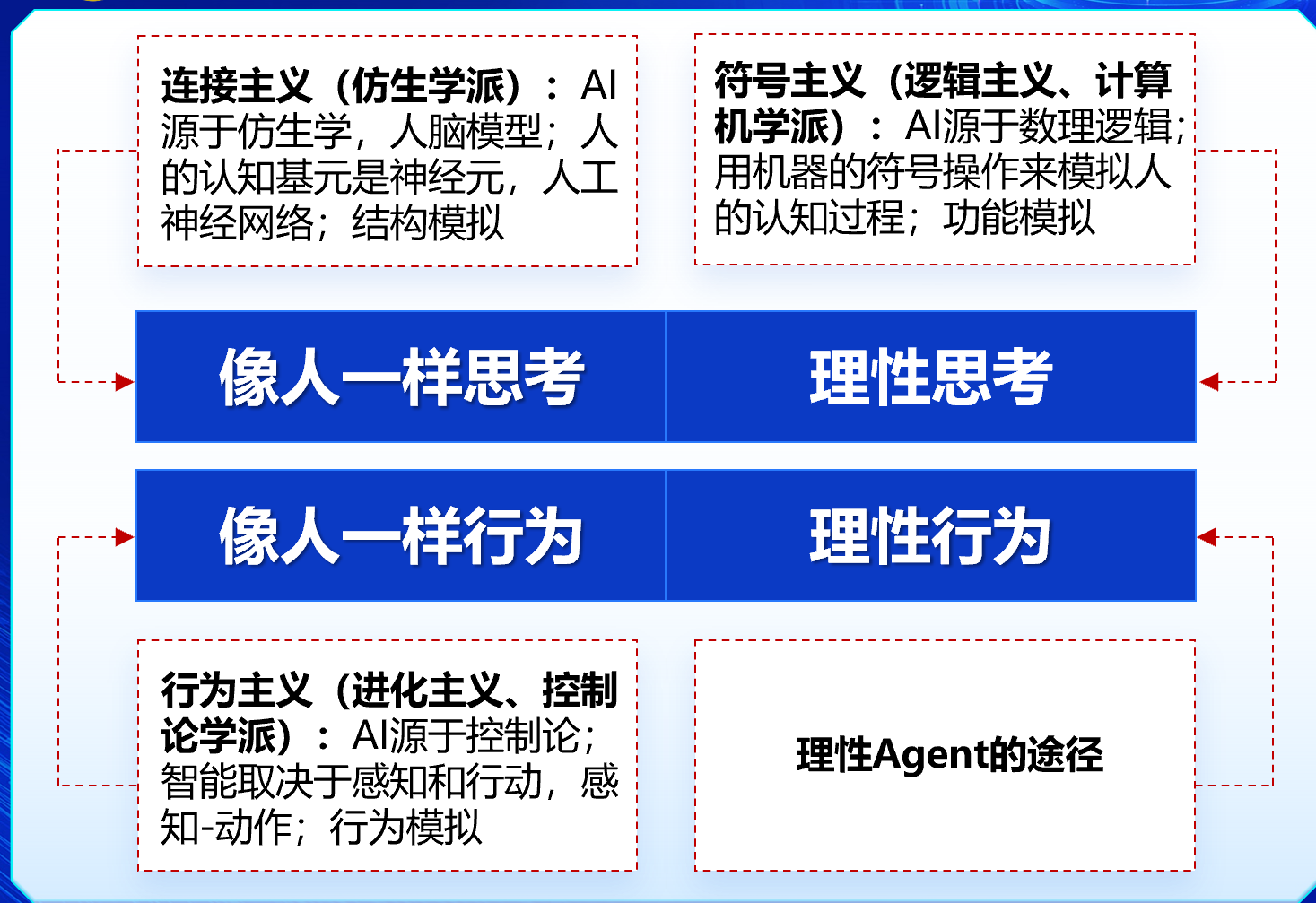

1. 能够列举并解释四类人工智能定义及其局限性

像人一样行为

- 图灵测试: 1950年,阿兰图灵提出了图灵测试,旨在为智能提供一个令人满意的可操作的定义。如果一位人类质询者在提出一些书面问题以后不能区分书面回答来自 人还是来自计算机,那么这台计算机就通过测试。

像人一样思考

神经元整合数千条信号输入,然后决定送到轴突的一个信号,可能是一个脉冲,也可能没有反应

- 逻辑主义流派

各种对象和对象之间的关系用逻辑表示法表示,用程序对逻辑表示法表示的问题求解

理性行为

基于已知信息以追求最大化目标收益

不一定有思考

2. 能够阐述理性Agent的概念

Agent 通传感器感知环境并通过执行器对所处环境产生影响

理性Agent:对每一个可能的感知序列,根据已知的感知序列提供的证据和Agent具有的先验知识,理性Agent应该选择能使其性能度量最大化的行动

Agent 函数

描述Agent行为的抽象数学表示

从任意给定感知序列到行为的映射

Agent程序

Agent函数的具体实现,在一些物理系统内部运行

Agent函数到Agent程序:理想到现实的失真

关系:Agent函数在一些物理平台上的具体实现,我们称为Agent程序。程序是能够确确实实在物理系统内部运行的。这里物理系统可以是PC机,也可以是机器人、无人机等嵌入式系统。

Agent函数是不考虑物理实现的数学抽象,而Agent程序是依赖于物理平台的,在Agent函数被Agent程序实现的过程中,受到物理平台的限制,往往会需要采取一些近似手段,从而导致失真。比如,在计算机平台上,计算出来的无限小数不能表示。

3. 解释树搜索和图搜索原理,并对比分析二者的不同

树搜索基本步骤:

- 初始化:将初始节点加入待扩展节点集合(通常是一个栈或队列)。

- 节点选择:从待扩展节点集合中选择一个节点进行扩展。

- 节点扩展:生成当前节点的所有子节点,并将这些子节点加入待扩展节点集合。

- 目标检测:检查生成的子节点是否为目标节点。如果是,则搜索成功;否则,继续扩展。

- 重复:重复步骤2-4,直到找到目标节点或待扩展节点集合为空。

图搜索基本步骤:

- 初始化:将初始节点加入待扩展节点集合(通常是一个优先队列)和已访问节点集合。

- 节点选择:从待扩展节点集合中选择一个节点进行扩展。

- 节点扩展:生成当前节点的所有子节点,并检查这些子节点是否已经存在于已访问节点集合中。

- 节点加入:如果子节点不在已访问节点集合中,则将这些子节点加入待扩展节点集合,并将当前节点标记为已访问。

- 目标检测:检查生成的子节点是否为目标节点。如果是,则搜索成功;否则,继续扩展。

- 重复:重复步骤2-5,直到找到目标节点或待扩展节点集合为空。

图搜索利用探索集记录已经扩展过的节点状态

4. 列举搜索算法的性能度量指标

完备性(Completeness)

- 当问题有解时,算法能否找到解

最优性(Optimality)

- 当问题有解时,算法能够找到最优解

时间复杂性(Time Complexity)

- 找到解需要花费多少时间

空间复杂性(Space Complexity)

- 在执行搜索的过程中需要多少存储空间

5. 阐述启发式函数的定义

启发式函数

借助搜索树结构以外的信息

估计当前结点到目标结点的路径代价

启发式函数值≠真实值

节点评估函数 f(n) = g(n)+h(n)

g(n) = 从根节点到节点n的路径开销

h(n) = 从节点n到目标节点的路径开销估计,启发式函数

f(n) = 从根节点经过n到达目标节点的路径开销估计

经过结点n的最小代价解的估计代价

6.环境的性质

7. 深度,宽度,一致代价三种无信息搜索的完备性,最优性,以及时空复杂度。

宽度优先搜索

如果b和d均有限,宽度优先搜索是完备的

如果b和d均有限,且单步代价相同,宽度优先搜索是最优的

- 分支因子 (Branching factor) b

- 状态空间中每个状态最多有b个后继状态

- 搜索树中最浅的目标结点的深度(Depth) d

- 目标结点的深度(Depth) d ≠ 初始状态到目标状态的路径代价(cost)

生成结点的总数 = $O(b^d) $

时空复杂性都是$O(b^d) $

一致代价搜索

如果b和d均有限,且每一步的代价都大于等于某个小的正常数ε,一致代价搜索是完备的

如果b和d均有限,且每一步的代价都大于等于某个小的正常数ε,一致代价搜索是最优的

- 分支因子(Branching factor) b

- 搜索树中最浅的目标结点的深度(Depth) d

- C* 表示最优解的代价

- 假设每个行动的代价至少为ε

生成结点总数(最坏情况) 为$O(𝒃^{(𝟏+⌊𝑪^∗/𝜺⌋ )})$

时间和空间复杂性均为$O(𝒃^{(𝟏+⌊𝑪^∗/𝜺⌋ )} )$

深度优先搜索

如果状态空间有限,深度优先图搜索算法是完备的,树搜索算法不是完备的。

深度优先搜索不是最优的。

- 分支因子(Branching factor) b

- 搜索树中最浅的目标结点的深度(Depth) d

- 叶结点最大深度m

生成结点总数(最坏情况) = $O(b^m)$

时间复杂度是$O(b^m)$

空间复杂度是$O(bm)$或$O(m)$

A*搜索

如果状态有限,检查重复状态,A*搜索则具有完备性

当启发式函数是可采纳的,A*算法的树搜索实现是最优的,图搜索不是最优的

8. 一致代价搜索为什么不在生成时进行目标检测。

在一致代价搜索中,第一个生成的目标节点并不一定是最优解。因为在生成该目标节点时,可能还有其他未被探索的路径能够以更小的代价到达目标节点。例如,从初始节点S到目标节点G,先生成了路径S-A-G,但后续可能还会生成路径S-B-C-G,且后者的总代价更小。如果在生成S-A-G时就进行目标检测并停止搜索,就会错过更优的路径S-B-C-G。在扩展时进行目标检测能确保找到的路径代价是最优的。

9. 八数码问题的两个启发式函数:

ℎ1(𝑛) = 不在位的棋子数

ℎ2(𝑛) = 所有棋子到其目标位置的曼哈顿距离和

10. 请简要描述人工智能、机器学习、及深度学习之间的关系。

机器学习是一种实现人工智能的方法,通过从数据中学习来使计算机具备智能行为。深度学习是机器学习的子集,指的是通过多层人工神经网络进行学习的算法。(人工智能>机器学习>深度学习)

11. PEAS描述无人战车任务情况

性能度量(P):任务目标完成情况,作战资源消耗情况……

外部环境(E):战场,操作员,对手,道路……

执行器(A):机枪等武器,转向设备,油门,刹车……

传感器(S):摄像头,雷达,导航等设备……

12. 宽度优先搜索和深度优先搜索的特点

参考完备性,最优性,以及时空复杂度回答。

13. 什么是评估函数?g(n)和h(n)分别起什么作用?

f(n) = g(n)+h(n)

g(n) = 从根节点到节点n的路径开销

h(n) = 从节点n到目标节点的路径开销估计,启发式函数

f(n) = 从根节点经过n到达目标节点的路径开销估计(经过结点n的最小代价解的估计代价)

14. 学习形式

无监督学习(unsupervised learning)

- 不提供显式反馈,Agent学习输入中的模式

- 目标是发现输入数据的关联或规律,输出往往是数据的另一种表示

- 例如:聚类

监督学习(supervised learning)

- Agent观察某些“输入-输出”对,学习从输入到输出的映射函数

- 以“输出”作为“输入”的反馈

- 输出是什么取决于学习任务是什么,如“条件-决策”“状态转换概率”“启发式函数”?

- 类比“有参考答案的学习”

- 分类(classification)

- 输出y的值域是有限集合,如sunny,cloudy和rainy

- 二分类(布尔分类):输出只有两个可能值

- 回归(regression)

- 输出y的值域是连续数值集合

- 分类(classification)

强化学习(reinforcement learning)

Agent在强化序列(奖赏和惩罚组合的序列)中学习

反馈是当前与预期结果的差异

根据对局过程改进博弈

类比“在实践中学习”

14. 同一组数据可能有多个一致假说,哪个更好?

奥坎姆剃刀(Ockham’s razor): 如果两个或多个处于竞争地位的理论能得出同样的结论,那么简单或可证伪的那个更好

假说空间如何设计:用简单的模型拟合样本。

15. 过度拟合

过度拟合:模型与训练数据的一致性高,但在测试数据上性能降低。

16. 为什么深度神经网络成功?

高度过参数化神经网络的非线性拟合能力

大量标注好的数据

GPU 的使用大大缩短了训练时间

15. 神经元MP模型

神经网络:由**神经元(Neuron)**按一定的层次结构连接起来

神经元模型 :

- 输入:来自其他 n 个神经元传递过来的输入信号

- 处理:输入信号通过带权重的连接进行传递, 神经元接受到总输入值将与神经元的阈值b进行比较

- 输出:通过激活函数的处理以得到输出

单层前馈神经网络 (感知机)

仅由两层神经元组成(输入层、输出层)

输入层接受外界输入信号传递给输出层, 输出层是M-P神经元(阈值逻辑单元)

16.MP神经元模型的6条基本假设:

- 神经元是多输入单输出的信息处理单元

- 神经元输入:兴奋性输入和抑制性输入

- 神经元具有空间整合特性和阈值特性

- 输入和输出间有固定时滞

- 忽略事件整合作用和不应期

- 突触时延和突出强度为常数

17. 卷积的基本概念

卷积核:在输入上多个局部区域重复的一个权值模式

卷积操作:将卷积核施加到图像的像素上的操作,即用权值向量对局部区域的像素进行线性组合

单通道卷积操作:对单通道输入图像,将卷积核放置在输入图像的一个位置,与覆盖区域做点乘并求和,得到输出的一个元素。将卷积核在输入图像上移动,即可得到完整的输出特征

实际意义:一个卷积核对应提取图片中一种局部特征,跟上面提到的动物视觉的特征提取类似

18. 池化操作

池化操作(下采样):对特征图进行特征提取,将其中最具有代表性的特征提取出来,可以起到减小过拟合和降低维度的作用

常见的池化操作:

- 最大池化

- 平均池化

优点:

- 在减少参数量的同时,还保留了原图像的原始特征

- 有效防止过拟合

- 为卷积神经网络带来平移近似不变性

19. 卷积神经网络结构

(卷积层+非线性激活层+池化层)* k + 全连接层

全连接层:对卷积层和池化层处理过的数据进行进一步的加工,输出最终结果。经过卷积层和池化层的降维,全连接层的计算成本大大下降,计算效率大幅提高

卷积操作的特性包括以下: